Precisión y exactitud

En ingeniería, ciencia, industria y estadística, exactitud y precisión no son equivalentes.[1]

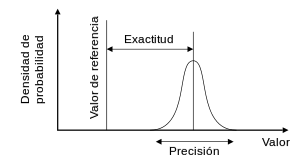

Precisión se refiere a la dispersión del conjunto de valores obtenidos de mediciones repetidas de una magnitud. Cuanto menor es la dispersión mayor la precisión. Una medida común de la variabilidad es la desviación estándar de las mediciones y la precisión se puede estimar como una función de ella. Es importante resaltar que la automatización de diferentes pruebas o técnicas puede producir un aumento de la precisión. Esto se debe a que con dicha automatización, lo que logramos es una disminución de los errores manuales o su corrección inmediata. No hay que confundir resolución con precisión.

Exactitud se refiere a cuán cerca del valor real se encuentra el valor medido. En términos estadísticos, la exactitud está relacionada con el sesgo de una estimación. Cuanto menor es el sesgo más exacta es una estimación. Cuando se expresa la exactitud de un resultado, se expresa mediante el error absoluto que es la diferencia entre el valor experimental y el valor verdadero.

Desde la aparición de la Guía para expresar incertidumbres de medida (GUM: JCGM-100 de la BIPM) algunos de los conceptos anteriores han sido revisados y el "error absoluto" no se considera medible ni estimable, desaconsejándose el uso de dicho término, pues el mensurando en ninguna manera puede ser conocido. Ver Incertidumbre (metrología)

Definición común

editarEn los campos de ciencia, ingeniería y estadística, la exactitud de un sistema de medición representa el grado de acercamiento de las medidas de una cantidad al verdadero valor de esa cantidad.[2] La precisión de un sistema de medición, se encuentra relacionado con la reproducibilidad y la repetibilidad; y se define como el grado en que la repetición de una medición en las mismas condiciones muestra los mismos resultados.[2][3] Aunque las dos palabras; precisión y exactitud pueden parecer sinónimas en el lenguaje coloquial, tienen un significado deliberadamente contrastante en el uso del método científico.

Un sistema de medición puede ser exacto, pero no preciso; preciso, pero no exacto; ninguna de las dos cosas; o ambas.

Por ejemplo, si un experimento contiene un error sistemático, al aumentar el tamaño muestral, generalmente mejora la precisión; pero no lo hace la exactitud. El resultado del experimento sería entonces una cadena consistente de resultados, aunque inexactos. La eliminación de errores sistemáticos mejora la exactitud, pero no influye en la precisión.

Un sistema de medición se considera válido si se comporta de ambas maneras, exacta y precisa. Otros términos relacionados son bias o sesgo (efectos unidireccionales en las mediciones causados por un factor o una serie de factores no relacionados con la variable independiente), y variabilidad o simplemente error que refiere a la variabilidad aleatoria.

La terminología también es aplicable a mediciones indirectas. Esto es, a valores obtenidos por procedimientos computacionales sobre datos observados.

Además de exactitud y precisión, las mediciones pueden también tener resolución, la que se define como el cambio más pequeño en la magnitud física que se está midiendo que es capaz de producir una respuesta en la medición.

En análisis numérico, la exactitud es también la cercanía de un cálculo al verdadero valor; mientras que precisión es la resolución de la representación, típicamente definida por el número de dígitos decimales o binarios.

La literatura estadística prefiere el uso de los términos sesgo y variabilidad, en lugar de exactitud y precisión: el sesgo es la cantidad de inexactitud y la variabilidad la cantidad de imprecisión.

Ejemplo

editarComo ejemplo de precisión y exactitud pongamos los disparos a una diana. La precisión y la exactitud en el disparo tienen que ver con la proximidad de los impactos entre sí (precisión), y con la concentración de los impactos alrededor del centro de la diana (exactitud).

En la figura A, tiene un alto grado de precisión dado que todos los disparos se concentran en un espacio pequeño, y un alto grado de exactitud dado que los disparos se concentran sobre el centro de la diana.

En la figura B, el grado de precisión es similar a la de la figura A. Los disparos están igual de concentrados; la exactitud es menor, dado que los disparos se han desviado a la izquierda y arriba, separándose del centro de la diana.

En la figura C, la precisión es baja como se puede ver por la dispersión de los disparos por toda la diana, pero la exactitud es alta porque los disparos se reparten sobre el centro de la diana.

En la figura D, la distribución de los disparos por una zona amplia denota la falta de precisión, y la desviación a la izquierda del centro de la diana revela la falta de exactitud.

Como puede verse estas propiedades son independientes y la alta o baja precisión no implica ni alta ni baja exactitud, una operación, la información o una medición es de tanto mejor calidad cuando mayor es su precisión y exactitud.

Cuantificación y estimación

editarEn instrumentación industrial, la exactitud es la tolerancia de una medición, o transmisión de un instrumento y define los límites de los errores cometidos cuando el instrumento está funcionando en condiciones operativas normales.[4]

En condiciones ideales, un instrumento de medición es tanto exacto como preciso, con todas las mediciones agrupadas estrechamente en torno al verdadero valor. La exactitud y precisión de un proceso de medición es, por lo general, establecido por la medición repetida de alguna referencia trazable técnicamente estandarizada. Estos estándares están definidos en el Sistema Internacional de Unidades, y mantenidos por organizaciones de estandarización nacionales.

Lo mismo aplica cuando las mediciones repetidas se promedian; en este caso, el término error estándar está apropiadamente aplicado. La precisión de la media es igual a la desviación estándar conocida para el proceso dividida por la raíz cuadrada del número de mediciones promediadas. Adicionalmente, el teorema central del límite muestra que la distribución de probabilidad de las mediciones promediadas se encuentra más cercana a una distribución normal que la de las mediciones individuales.

Con respecto a la exactitud cabe distinguir:

- La diferencia entre la media de las mediciones y el valor de referencia, es decir el sesgo o bias. Establecer y corregir el efecto del sesgo es necesario para realizar una calibración.

- El efecto combinado de la exactitud y de la precisión.

Una convención común en ciencia e ingeniería es la de expresar la exactitud y la precisión implícitamente por medio de cifras significativas. De esta forma cuando no se encuentra explícitamente definido, el margen de error se sobreentiende como la mitad del valor de la última cifra significativa. Por ejemplo, un registro de 843,6 m, o 843,0 m, o 800,0 m implicaría un margen de 0.05 m (el lugar de la última cifra significativa es el de los décimos), mientras que un registro de 8 436 m implicaría un margen de error de 0,5 m (la última cifra significativa es la de las unidades).

Una lectura de 8 000 m, con ceros encadenados y sin coma decimal es ambigua; los ceros encadenados pueden o no ser interpretados como cifras significativas. Para evitar esta ambigüedad, el número debe ser representado en notación científica: así 8,0 x 103 m indica que el primer cero es significativo (representando aquí un margen de 50 m) mientras que 8,000 x 103 m indica que los tres ceros son significativos, dando un margen de 0,5 m. En forma similar es posible utilizar un múltiplo de la unidad básica de medición: 8,0 km es equivalente a 8,0 x 103 m. De hecho, esto indica un margen de 0,05 km (50 m). Sin embargo, atenerse a esta convención puede conducir a errores de falsa precisión cuando se aceptan datos de una fuente que no la obedece.

La precisión algunas veces se estrafica en:

- Repetibilidad — es decir la variación que se observa cuando todos los esfuerzos se centran en mantener las condiciones constantes utilizando el mismo instrumento y operador, y realizando las repeticiones en un período corto de tiempo.

- Reproducibilidad — es decir la variación que surge de utilizar el mismo proceso de medición entre diferentes instrumentos y operadores y a lo largo de extensos períodos de tiempo.

Definición según normas ISO (ISO 5725)

editarHa habido un cambio en el significado de estos términos con la publicación de la serie de estándares de las normas ISO 5725 en 1994, el cual se refleja además en la publicación del BIPM International Vocabulary of Metrology (VIM), en los ítems 2.13 y 2.14.[2]

De acuerdo a la ISO 5725-1,[5] el término general "exactitud" se utiliza para describir la cercanía de una medición al verdadero valor. Cuando el término se aplica a un grupo de mediciones sobre un mismo mensurando, implica una componente de error aleatorio y una componente de error sistemático. En este caso la veracidad es la cercanía de la media de un grupo de mediciones al verdadero valor y precisión es la cercanía de agrupación entre un grupo de resultados.

Las ISO 5725-1 y VIM además evitan el uso del término "sesgo", que anteriormente se especificaba en BS 5497-1,[6] debido a que tiene diferentes connotaciones por fuera de los campos de la ciencia y la ingeniería, por ejemplo en el campo de la medicina y legal.

En clasificación binaria

editarLa exactitud se utiliza también como una medida estadística de que tan bien una prueba de clasificación binaria identifica correctamente o excluye una condición.

Esto es, la exactitud es la proporción de resultados verdaderos (tanto verdaderos positivos (VP) como verdaderos negativos (VN)) entre el número total de casos examinados (verdaderos positivos, falsos positivos, verdaderos negativos, falsos negativos).[7] Para dejar en claro el contexto por la semántica, a menudo se refiere como "exactitud Rand" or "índice Rand".[8][9][10] Es un parámetro de la prueba.

Una exactitud del 100% significa que los valores medidos son exactamente los mismos que los dados.

Por otro lado, la precisión o valor predictivo positivo se define como la proporción de verdaderos positivos contra todos los resultados positivos (tanto verdaderos positivos, como falsos positivos)

Precisión y exactitud numérica

editarPrecisión numérica se refiere al valor real con una cierta cantidad de dígitos que representan al valor.

≈

Exactitud numérica se refiere al valor real con todo los dígitos que representan al valor.

Referencias

editar- ↑ Skoog, Douglas A. (2009). Principios de Análisis Instrumental (6 edición). PARANINFO, S.A. p. 965. ISBN 9789-70686-829-9.

- ↑ a b c JCGM 200:2008 International vocabulary of metrology — Basic and general concepts and associated terms (VIM)

- ↑ Taylor, John Robert (1999). An Introduction to Error Analysis: The Study of Uncertainties in Physical Measurements. University Science Books. pp. 128-129. ISBN 0-935702-75-X.

- ↑ Creus, Antonio. Instrumentación Industrial[cita requerida]

- ↑ BS ISO 5725-1: "Accuracy (trueness and precision) of measurement methods and results - Part 1: General principles and definitions.", p.1 (1994)

- ↑ BS 5497-1: "Precision of test methods. Guide for the determination of repeatability and reproducibility for a standard test method." (1979)

- ↑ Metz, CE (October 1978). «Basic principles of ROC analysis». Semin Nucl Med. 8 (4): 283-98.

- ↑ «Copia archivada». Archivado desde el original el 11 de marzo de 2015. Consultado el 2 de abril de 2016.

- ↑ http://arxiv.org/pdf/1503.06410.pdf

- ↑ «Copia archivada». Archivado desde el original el 4 de marzo de 2016. Consultado el 2 de abril de 2016.

Bibliografía

editar- Ramon Pallàs Areny (2004). La precisión de la química (5ª edición). Marcombo. ISBN 978-84-267-1344-5.